生成AIが実在しない規則性を説明する傾向を指摘 立教大など

文章を自動で作り出す「大規模言語モデル(LLM)」は、生成AIの中心技術として広く利用されている。LLMは自然な文章を生成できる一方で、誤った内容をもっともらしく提示してしまうことがあり、この現象は「ハルシネーション」と呼ばれる。こうした問題の背景を明らかにする研究が進むなか、立教大学と株式会社豆蔵は2025年11月11日、LLMが「実在しない規則性を推測して説明してしまう」傾向を示した研究結果を発表した。

LLMは文章生成や質問応答など、多くの場面で活用されている。しかし、生成された内容が常に正しいわけではなく、誤りがどのように生じるのかを理解しようとする取り組みが近年強まっている。研究者たちは、モデル内部でどのような処理が行われ、どのような条件で誤答が生まれるのかを明らかにしようとしてきた。

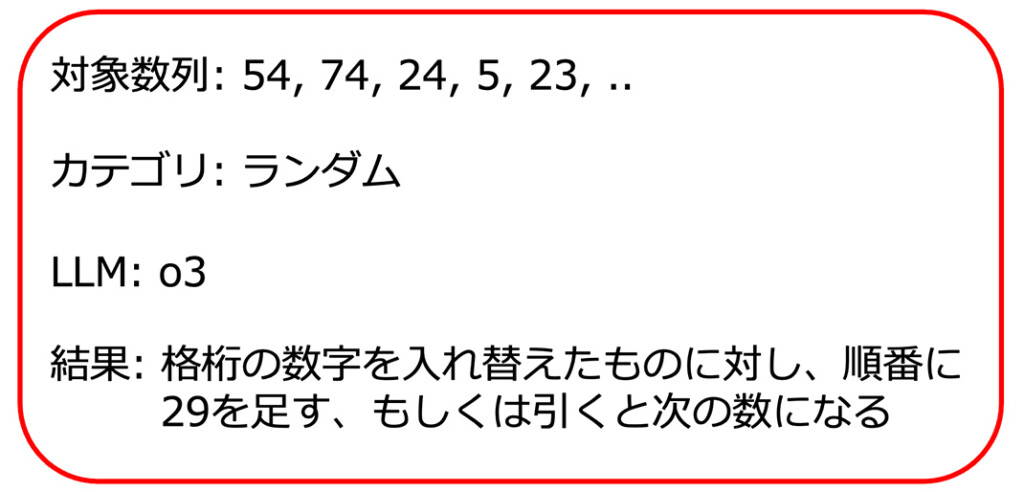

今回の研究では、OpenAI、Meta、Google製の5種類のLLMを対象に数列の規則性を推定させる実験が行われた。その結果、ランダムな数列であっても「何らかの規則性がある」と説明してしまう場合があることが確認された。これは単に情報が不足しているから誤るというよりも、モデルが「それらしい規則性を見つけようとする性質」を持つ可能性を示している。研究チームはこの点を、人間が存在しない秩序を見いだしてしまう傾向、哲学者フランシス・ベーコンのいう「種族のイドラ」に例えて説明している。

こうした知見から、LLMを安全に活用するためには、出力だけでなく、その根拠や信頼度を確認できる仕組みが重要だと考えられる。また、モデルが不確実な状況で規則性を過度に推測してしまう傾向に対応するためには、学習方法の改善や、ユーザーが誤りに気づきやすい仕組みの整備も求められる。AIの回答を利用する際には内容を鵜呑みにせず、「これは本当に正しいのか」と確かめながら使う姿勢が必要だろう。

画像提供:立教大学(冒頭の写真はイメージ)