スーパーコンピュータ「富岳」で日本語特化の大規模言語モデルを公開 東工大など

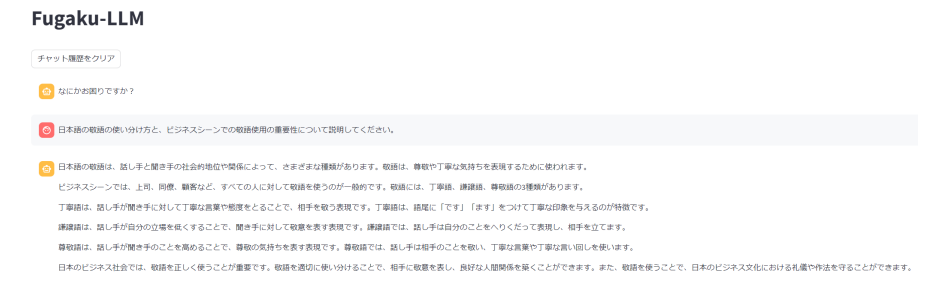

東京工業大学などは10日、スーパーコンピュータ「富岳」を用いて学習した、日本語能力に優れた大規模言語モデル「Fugaku-LLM」を同日に公開したと発表した。そのソースは公開されており、ライセンスに従う限りにおいて研究や商業目的での利用が可能だ。今後、多くの研究者や技術者が基盤モデルの改善や新たな応用研究に参画することで、さらに効率的な学習方法が創出され、次世代の革新的な研究やビジネスでの応用につながることが期待される。

言語モデルとは、言葉をコンピュータに処理させる自然言語処理などにおいて、文の品詞や統語構造、単語と単語、文書と文書などの関係性について定式化したもののこと。さらに大規模言語モデル(LLM: Large Language Model)は、膨大なデータから生成された汎用の言語モデルであり、AIによる、より自然な言語処理・言語表現を可能にするもの。一般的には、テキスト分類や感情分析、情報抽出、文章要約、テキスト生成、質問応答といった、さまざまな自然言語処理を行うことができる。

LLMは、最初は米国を中心に英語での開発が進められた。英語以外の言語についても、各国で自国のLLMを開発するために莫大な人的資源や計算資源が投入されている。日本語に特化したLLMも多数発表されているが、日本のスーパーコンピュータのフラッグシップシステムである富岳における、大規模な分散並列計算を実施するための環境整備が求められていた。

今回、東京工業大学、東北大学、富士通、理化学研究所、名古屋大学、サイバーエージェント、Kotoba Technologiesの研究グループにより、富岳におけるLLMの研究開発が進められた。

富岳に深層学習フレームワークを移植することと通信性能を最適化することで、LLMを学習する際の演算速度を既存技術の6倍、通信速度を3倍に高速化することに成功した。これにより富岳のCPUを用いて、現実的な時間内でLLMを学習することが可能になった。

今回開発されたLLMは、国内で多く開発されている70億パラメータより一般に高性能、かつ現在の計算機環境下で扱いやすい130億パラメータのモデルとした。また、従来の日本語が扱えるLLMの多くが他言語で開発されたモデルにさらに日本語を追加学習させたものであるのに対し、今回のLLMは一から独自のデータを用い学習を行っているため、全学習工程を把握できて、透明性と安全性の観点から優れているという。学習データの約60%が日本語コンテンツであり、日本語、特に人文社会系のタスクでのベンチマークテストで高性能を発揮した。

富士通製の国産CPUを中央演算処理装置とした富岳を用いて大規模言語モデルを学習できたことは、日本の半導体技術の活用や、経済安全保障の観点からも重要な成果だという。また、今回の取り組みで得られた知見は、富岳の後の次世代計算基盤の設計に活かされうるものであり、AI分野における日本の優位性確立に貢献していくとしている。

画像提供:東京工業大学